Odpálím to rovnou spoiler alertem: to, co dnes označujeme za AI, skutečným AI (zatím) není. Ve skutečnosti dnes fungujeme s natrénovanými modely, které dokáží překvapivě důmyslně doplňovat další krok a vytvářet tím dojem simulované inteligence blízké té lidské. To se ale každým týdnem mění a už dnes to z této technologie nedělá o nic menší revoluci, než jakou je!

Jedna konkrétní a výstižná definice AI neexistuje a pojmenování AI běhá po Internetu spousta: od „komplexní entity postavené na křemíku“ po „hyperkorektního mileniála z Karlína“ od Miloše Čermáka (vysvětlím závěrem). Podle mě popisuje AI nejvýstižněji malá snaha na vstupu <> obrovské WOW na výstupu! Abyste si však udělali vlastní představu, pojďme si v kostce vysvětlit, jak strojové učení (Machine Learning, ML) funguje.

ML je tak trošku duchařina. V principu jde o učící se entity, které se procesem učení samy zdokonalují. Představete si takový nejjednodušší scénář, ve kterém vy coby uživatel zadáte vstupy (hyperparametry) a necháte na modelu pochopit vztahy mezi nimi, aby vám na konci dodal výstup (textový, obrazový, zvukový, multimediální,…). Na velmi obecném a velmi jednoduchém příkladu probíhá výpočetní proces tak, že model průběžně přiřazuje různým proměnným náhodné váhy a z těch se dobírá výsledků. Ty si následně porovnává oproti historickým/tréninkovým datům, výsledky samozřejmě netrefí, ale zjistí si velikost a směr odchylek, aby celý dataset poučeně přepočítal (back propagation). Jedné takové iteraci se říká epocha a těch musí jich opakovaně proběhnout minimálně desetitisíce. Výše popsaný typ machine learningu se nazývá Supervised Learning, kdy má model v tréninkové sadě správnou odpověď a z té se učí předpovídat výstupy odpovídající novým vstupům. „Učení s učitelem“ se používá pro klasifikaci dat anebo rozpoznávání objektů. Druhý přístup je logicky Unsupervised Learning, kdy model nemá v tréninkových datech správné odpovědi a strukturu a vzory v datech si musí hledat sám. Typické použití tohoto „učení bez učitele“ je například u detekce anomálií, anebo segmentaci trhu na základě nějakého chování (např doporučování produktů). A posledním přístupem je Reinforced Learing, kdy se model učí posilováním v podobě maximalizace odměny v případě, kdy jeho akce vedou k pozitivním výsledkům. „Učení posilováním“ se typicky používá ve hrách a nejrůznějších optimalizačních úlohách.

Každé trénování je obrovsky nákladné, proto existují knihovny tzv open-source modelů, abyste nemuseli začínat od nuly, ale vzít zjištěné váhy a svůj model si jen dotrénovat na vašich vlastních datech. Pokud použijete jen zjištěné váhy, jedná se o open-weight model, použitím open source modelu přebíráte kompletní model, tedy kromě vah i odladěnou architekturu modelu.

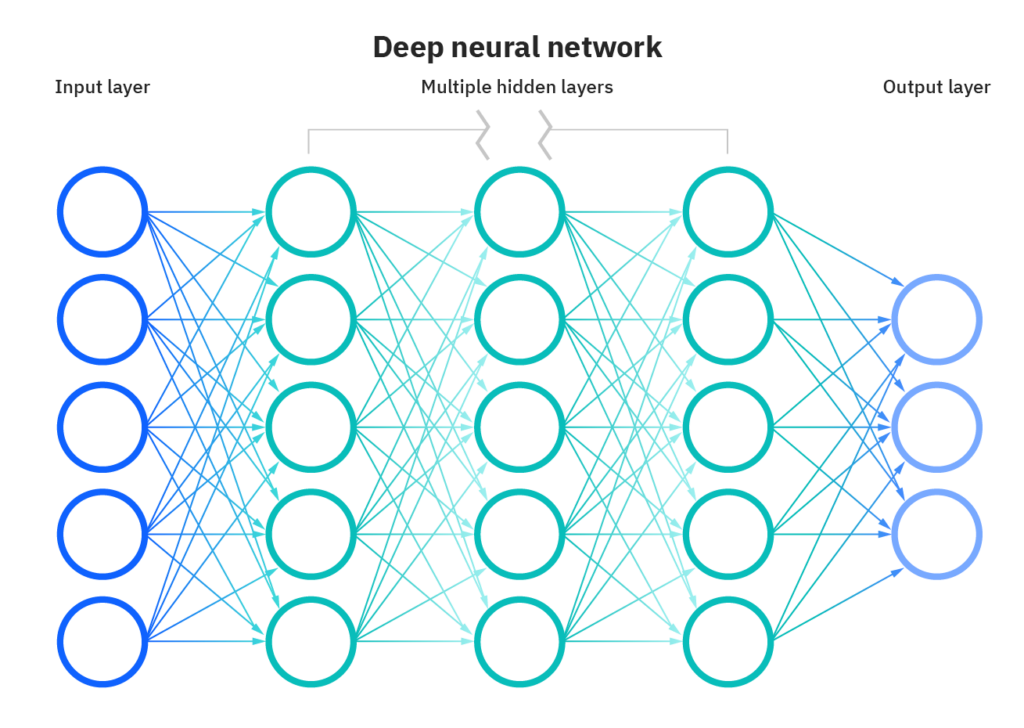

Architekturou označujeme mozek ML, tedy způsob, jakým a jak komplexně je „zadrátovanej“. Pro komplexnější úlohy a pro dosažení lepších výsledků je totiž nutné výše popsaný nejjednodušší ML model kapacitně naddimenzovat. Toho dosáhneme tím, že necháme stroj vkládat mezi vstup a výstup hlubší neuronové vrstvy (Deep Learning, DL), mezi kterými si hledá další vážené vztahy a celý proces se náročností mnohonásobně multiplikuje. S každou další vrstvou tak vzniká další učící moment a nová množina synapsí.

Důležité přitom je, aby se model dokázal na trénovacích datech naučit a následně se potvrdit na testovacích datech. Když bude „příliš chytrý“, tedy kapacitně přežhavený, nejen že bude zbytečně drahý, ale nadrtí se zadání „nazpaměť“, namísto aby porozuměl vztahům mezi veličinami. To nechceme. Takový scénář je označovaný jako model overfit, a odhalí se v momentu, kdy model na trénovacích datech skóruje 100%, ale propadne na datech testovacích.

Historicky není AI úplně mladá doména, nicméně masově nás ohromila teprve ve chvíli, kdy velmi obstojně ovládla jazyk. To bylo na podzim roku 2022, kdy OpenAI představila ChatGPT, zatímco do té doby bylo používání jazyka svrchovanou doménou lidí. Jak jsem nastínil úvodem a jak si v kapitlole Generování textu později vysvětlíme, šlo o revoluční, socio-kulturní milník, nicméně realita je stále taková, že velké jazykové modely (LLM) pouze doplňují slova a tím simulují lidské vyjadřování a na rozdíl od lidí neumí indukovat a dedukovat, nezvládnou se pohybovat ve vícemodálních kontextech (například když ráno uvidí skleničku vody na stole, nenapadne je, že jste se včera vrátili z večírku společensky znavení pozdě večer). Naštěstí.

A ještě jedna důležitá poznámka. Generativní AI modely jsou tzv emergentní, nikoliv deterministické, jinými slovy vykazují chování a vlastnosti, které jim nebyly naprogramovány. Díky této své vlastnosti dokáží generovat odpovědi a řešení problémů, na které nebyly explicitně natrénovány a na základě naučených dat generalizují na nové, neviděné situace. Jejich výstupy proto mohou být nečekané a překvapivé (vžil se termín, že modely „halucinují„). Halucinace jsou přirozenou vlastností modelů, která se dá různě moderovat, nejedná se však o chybu. Koneckonců i my, lidé, nejsme vždycky správní, přesní, faktičtí…

A závěrem k tomu „hyperkorektnímu intelektuálovi z Karlína“. Vysvětlíme si, že generativní modely jsou trénovány na obrovských datasetech (tzv korpusech). Aniž by byli tvůrci modelů kolem trénovacích dat transparentní, představte si knihovny textů, obrazů, zvuků, diskuse pod články, Wikipedii (menší procento) a velkou část obsahu Internetu, jehož polovinu představuje tzv dospělý obsah (prostě porno). Je potom úsměvné, že když stočíte konverzaci lechtivým směrem, AI zablokuje další pokračování a odmítne odpovídat, jakoby dospělého obsahu na světě nebylo 🙂

Jak ale adresovat uživatelské požadavky na spolehlivost, vysvětlitelnost, etiku a bezpečnost si řekneme v kapitole První AI projekty ve firmě a kapitolách následujících.